Ist Virtual Production die Zukunft des Filme machen?

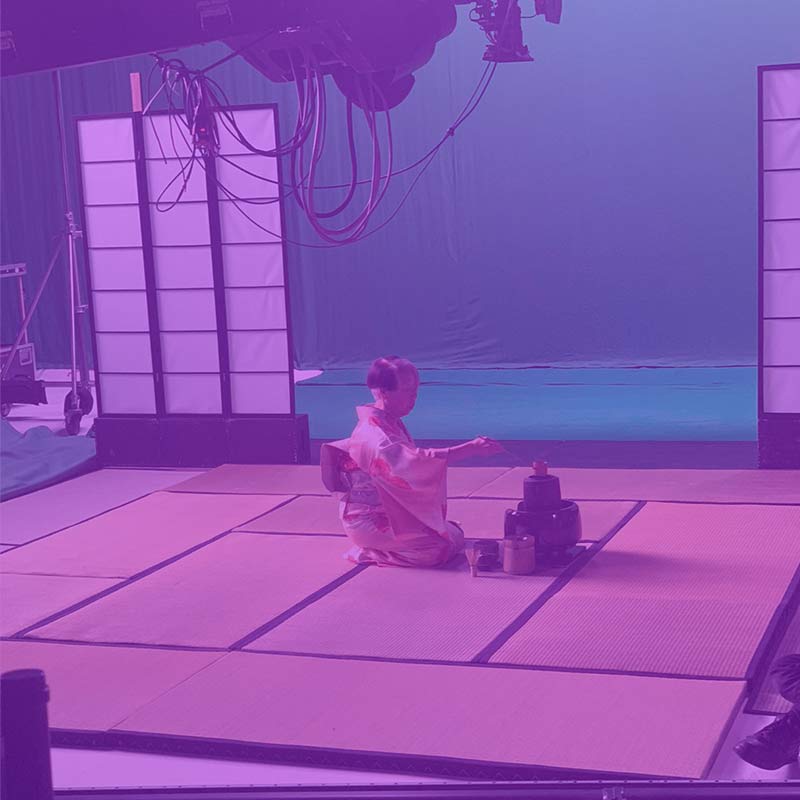

Setup des Virtual Production Showcase CARGO in unserem berliner MoCap Studio

Das letzte Jahr hat scheinbar jedes Paradigma in der modernen Welt verschoben. Obwohl jede Branche hart getroffen zu sein scheint, ist die Film- und Fernsehproduktion in dieser Zeit mehr oder weniger zum Stillstand gekommen. Die finale Staffel von Better Call Saul wurde um mindestens ein Jahr verschoben, da die Produktion Risiken für Darsteller und Crew mit sich bringt. Daniel Craig, der wahrscheinlich dachte, er wäre inzwischen in Bond-Rente, wird mindestens zwei Jahre warten müssen, wenn „No Time to Die“ veröffentlicht wird. Sogar der unerschütterliche Tom Cruise verlor bekanntermaßen am Set der „Mission: Impossible“-Folgen die Beherrschung und schimpfte über seine eigene Crew, weil sie sich nicht an die Sicherheitsprotokolle hielten – und das in einer Branche, in der die Produktion stillgelegt wurde.

Selbst wenn sich die Pandemie beruhigt und das normale Leben wieder einsetzt, wird die Film- und Fernsehproduktion Zeit brauchen, um wieder in Schwung zu kommen. Die Autoren werden wieder in überfüllten Schreibstuben sitzen und an den Handlungssträngen, Plots und Drehbüchern feilen, die eine Serie braucht. Und die Versicherungen werden zögern, große Produktionen zu versichern, da es zu einem Stillstand aufgrund eines Virenausbruchs kommen könnte. In Zukunft werden die Produktionen vielleicht eher im kleinen Rahmen mit einer kleinen Besetzung und Crew stattfinden.

In Anbetracht der Tatsache, dass sich alles ändern wird, glaubt OnPoint Studios, dass die virtuelle Produktion, die sie in ihrem Büro und Studio in Berlin entwickelt und getestet haben, an Popularität gewinnen wird.

Niklas Bothe ist Head of Motion Capture bei OnPoint Studios. „Virtual Production“, sagt er, „ist, wenn wir Live-Action und Computergrafik in Echtzeit kombinieren. Das bedeutet, dass der Regisseur und die Leute, die für ihn arbeiten, Dinge, ohne einen langwierigen Postproduktionsprozess, anpassen, überwachen und ändern können.“

Face capture Experte Kevin nimmt die letzten Anpassungen für das Capture der Mimik vor

Die Kombination von Live-Action und computergenerierten Bildern (CGI) ist nichts Neues. Es ist ein Prozess und eine Technik, die seit dem Erscheinen des originalen Star Wars im Jahr 1977 üblich ist. Selbst die am wenigsten an der Filmproduktion interessierte Person weiß, was „Green Screen Technologie“ ist. Aber bisher war es immer so, dass die Live-Elemente des Drehs zuerst gemacht wurden und die Spezialeffekte erst Wochen oder sogar Monate später hinzugefügt wurden. Dies bedeutete oft, dass der Regisseur ein gewisses Maß an Kontrolle über seine Arbeit verlor, da er auf die Beschränkungen dessen, was er hat und was er damit machen kann, beschränkt war.

Virtual Production unterscheidet sich dadurch, dass diese Elemente – die Live-Aufnahme und das Hinzufügen von CGI-Effekten – gleichzeitig stattfinden. Der Regisseur beobachtet die Schauspieler mit seinen eigenen Augen, während er gleichzeitig auf einen Monitor schauen kann und sieht, wie die spätere Szene aussehen wird. Das gibt diesen Produktionen die Flexibilität, Dinge im laufenden Betrieb zu ändern und anzupassen.

Big-Budget-Produktionen wie Disneys „The Mandalorian“ nutzen diese Methode bereits. Jedoch gibt es weitaus mehr Anwendungsmöglichkeiten. Virtuelle Produktionen können für Künstler verwendet werden, die live auftreten und ihre Performance mit Spezialeffekten untermauern; Theaterproduktionen, die über das Internet gestreamt werden, können mit spektakulären Effekten versehen werden; oder in Online-Foren und Konferenzen können Gastgeber und Gäste mit animierten Figuren oder Effekten interagieren.

Darstellerin während der Aufnahme unseres Virtual Production Showcases CARGO

Während schockierende Effekte von einer Performance ablenken können (Hallo, The Rock in The Scorpion King), können solche, die mit virtuellen Produktionen verstärkt werden, über eine Reihe von Kanälen gestreamt werden, darunter YouTube, Twitch aber auch in Virtual Reality. All dies sind in der Regel eindringlichere Erlebnisse, die anders sind als in einem abgedunkelten Theater zu sitzen und Menschen bei der Interaktion mit… nun ja, anderen Menschen zu beobachten.

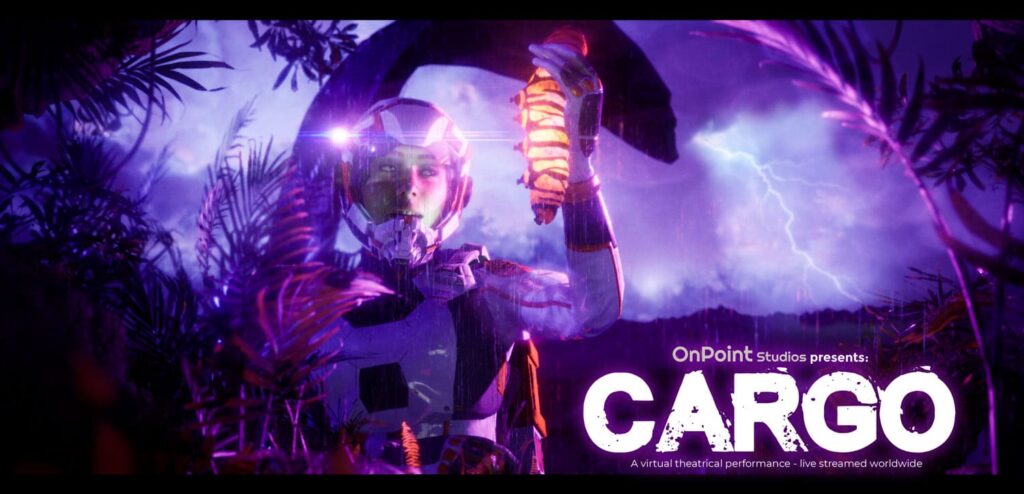

Das Team von OnPoint schuf CARGO, um seine Arbeit zu präsentieren und die Qualität der Live-Vorschau auf ein Niveau zu heben, das mit etwas konkurrieren kann, das vorher aufgezeichnet wurde. Die Inspiration hinter CARGOs Thema ist Jurassic Park, aber im Weltraum, sagt Facial Capture Supervisor Kevin Clare.

„Die Idee hinter dem Projekt war, dass wir ein Vehikel brauchten, um die Möglichkeiten zu zeigen, die den Kreativen offenstehen, wenn sie hochqualitatives Motion Capture, die Unreal Engine und andere Virtual Production Techniken kombinieren. Wir wollen nicht nur das Qualitätsniveau so weit wie möglich steigern, sondern auch Werkzeuge für Regisseure, DPs, Kameraleute usw. entwickeln. Es ist uns wichtig, diese Kreativen zu unterstützen, indem wir sie nicht zwingen, neue Techniken zu verwenden, sondern ihnen Werkzeuge zur Verfügung stellen, mit denen sie bereits vertraut sind.“

Bei den Motion Capture Studios im Norden Berlins haben Niklas, Kevin und Marian Woller, Leiter der Abteilung Virtual Stage, das letzte Jahr damit verbracht, die Technologie und Software zusammenzustellen, die das hochmoderne virtuelle Produktionsangebot des Unternehmens ausmachen.

„Wir haben ein Jahr lang daran gearbeitet“, sagt Marian, „und obwohl es eine Menge Arbeit und manchmal eine Herausforderung war, haben wir angesichts des Zustands der Welt einen Punkt erreicht, an dem wir für die meisten Produktionsgrößen gerüstet sind. Angesichts all dessen und der Arbeit, die wir geleistet haben, können wir jedem, der die virtuelle Produktion nutzen möchte, einen hochwertigen Output bieten.“

Das Keyart von CARGO zeigt wie Ally eine Art Raupe in ihrer Hand hält

Zum Trailer von CARGO auf YouTube.